随着单芯片的能耗和单机柜的密度在不断上升,数据中心发展液冷已经成为行业共识。但在行业大规模应用之前,液冷标准的匮乏和产业不成熟,成为当前液冷产业最大的制肘。

过去一年,浪潮信息做了一两百次的客户交流,话题都很一致,聊的都是液冷,这个数字比前一年增加了10倍以上,“大家都觉得液冷就是未来最重要的一个发展趋势。” 浪潮信息服务器产品线总经理赵帅表示。

英特尔市场营销集团副总裁中国区数据中心销售总经理庄秉翰透露,国内几个服务器使用的头部行业,如互联网、运营商、金融行业等,目前对液冷都已经完成了POC阶段,进入到了规模化采用的状态。

欢迎来到液冷时代

液冷服务器的整体市场表现直观地反映出这种趋势。IDC发布的《中国半年度液冷服务器市场跟踪》报告显示,2023上半年中国液冷服务器市场规模达到6.6亿美元,同比增长283.3%,预计2027年市场规模将达到89亿美元。

“随着液冷技术的标准化和液冷产品的部署成本下降,液冷进入了一个高速推广和应用的阶段。”信通院产业与规划研究所副总工程师王青说,头部的互联网公司和三大运营商已经在积极推动液冷项目试点。

作为行业先行用户,阿里巴巴、京东等互联网头部企业都已经建设了液冷数据中心。而运营商也在行动。2023年6月,三大运营商联合发布液冷技术白皮书,提出“三年愿景”:即2023年开展液冷技术验证;2024年开展规模测试,新建数据中心项目10%规模试点应用液冷技术,推进产业生态成熟;2025年及以后开展规模应用,50%以上数据中心项目应用液冷技术。

据测算,到2025年液冷渗透率有望来到20%以上,“当前基本上所有的运营商,银行都在新建的数据中心规划了液冷,但是真正的建设应该会在2024年初大量开始。”

液冷成为行业焦点的背后,数据中心散热走到了十字路口。过去的风冷散热越来越难以满足需求,发展液冷已经成为行业共识。

背后的原因在于,一是处理器性能不断提升,传统的风冷散热越来越难跟上需求。比如英特尔第四代至强处理器最高支持60个核,而未来一两年,这个数量将达到一两百核。

通用算力从2019年的最高205W,快速演进到2022年的四五百瓦,“传统风冷散热在400瓦以上会遇到巨大挑战。”信通院王青说。风冷已经在经济性和散热效率上达到极限,而散热跟不上,会影响到处理器的运行效率和使用寿命,带来资源的浪费。

更严峻的挑战来自于这几年智能算力需求的爆发,尤其是大模型的兴起催生了对AI算力的庞大需求。OpenAI的数据显示,到ChatGPT4的参数规模以后,每三到四个月它的算力规模会翻一倍。有机构预测,到2025年,智算的需求是当前100倍,呈指数型的增长。

AI算力相比于通用算力,功率更高,对散热的要求更加苛刻。GPU的功耗从2017年大概300瓦的规模,到2022年已经达到了七八百瓦的规模。单机芯片密度更高的GPU在散热方面将遇到更大挑战。

除了自身的散热需要。数据中心作为能耗大户,国家层面对数据中心的PUE有着越来越严格的要求。比如全国新建大型、超大型数据中心的PUE要降到1.3以下,北京甚至要求新建数据中心PUE值小于1.2。而传统风冷数据中心的PUE目前能到1.4-1.5,液冷则可以做到近1.1。

这些硬性指标背后,意味着行业亟需寻求更加高效的散热方式。“现在处理器的功耗越来越高,想发挥出处理器的最高性能,不用液冷解决不了散热。”

据测算,要实现1000kW散热,如果完全使用传统风冷空调,需要消耗约500kW电能;采用风液混合冷却,主要液冷散热,结合空调风冷辅助,需要消耗约100kW电能;而使用全液冷散热则仅需要消耗约30kW电能。由此可知,全液冷相较风冷节能高达90%以上,数据中心液冷占比越高,则节能收益越明显。

规模越大,液冷优势越明显

相比于风冷以风扇、空调等空气换热的方式散热,液冷是以矿物油、氟化液等作为冷媒,带走服务器里的热量。

由于液冷的单位体积比热容是风冷的1000倍以上,所以目前液冷PUE普遍能做到1.1,甚至不断逼近1.0。而在机柜功率密度方面,2020年风冷数据中心平均机架功率为8.5kW/机柜,而液冷单机柜功率密度可超100kW,两者也是相差10倍以上。

以布置了200台浪潮信息高密度服务器i24M7的数据中心为例,在风冷散热条件下数据中心PUE为1.58,采用风液混合散热PUE可降至1.16,实现全液冷冷板散热则可将PUE降至1.05以下。

液冷分为直接液冷和间接液冷,比如浸没式液冷属于直接液冷,把整个机柜都泡在冷却液中;而冷板式液冷,通过冷板来传导,实现散热效果,属于间接液冷。目前,浸没式液冷由于技术尚未成熟,成本较高,大规模应用尚需时日,而冷板式液冷在整个液冷市场的应用比例超过了90%。

相比于其他液冷散热方式,冷板式液冷对机柜和服务器的改造最小,冷却液不直接接触芯片和服务器内的其他部件,对材料兼容要求比较低,可以跟不同厂商和型号的计算设备兼容,为客户提供更多的硬件的选择空间。

而且在运维方面,不改变客户的使用习惯和运维模式。在最大限度利旧的情况下,冷板式液冷可以保证在原有空间、供电、承重等因素基本不变的前提下,大大提升散热效果,甚至还可以帮助老旧数据中心实现平台升级的再度兼容,这样也可以实现许多东部数据中心的改造利用。

除了兼容利旧、方便部署外,成本也是外界在选择液冷时非常关注的话题。

“2023年,整个液冷数据中心1KW的散热成本,有望下降到5000元。”王青说。

“与风冷相比,冷板式液冷初期建设成本要高一点,但数据中心运营1.5年左右即可回收成本”,浪潮信息数据中心产品部副总经理李金波说。不过,随着产业链的成熟和标准的建立,浪潮信息预计将在2025年做到“风液同价”。

赵帅透露,近年坚定上液冷的用户主要有两类:一类是超大规模部署的用户,“越大的客户,上液冷的反而是越多”,规模越大,液冷的效果越明显;另一类是智算中心的用户,AI算力的功耗更大,对散热的需求更强烈,“单机功耗在6千瓦到12千瓦时,上液冷的TCO收益是非常高”。

当然,《全液冷冷板系统参考设计及验证白皮书》也指出,液冷服务器当前也存在一些难点。比如除CPU、GPU、内存之外,目前业界对服务器内其他发热部件如何通过冷板液冷实现散热的探索还比较少,方案尚未成熟,无法灵活适用于传统通用服务器架构。

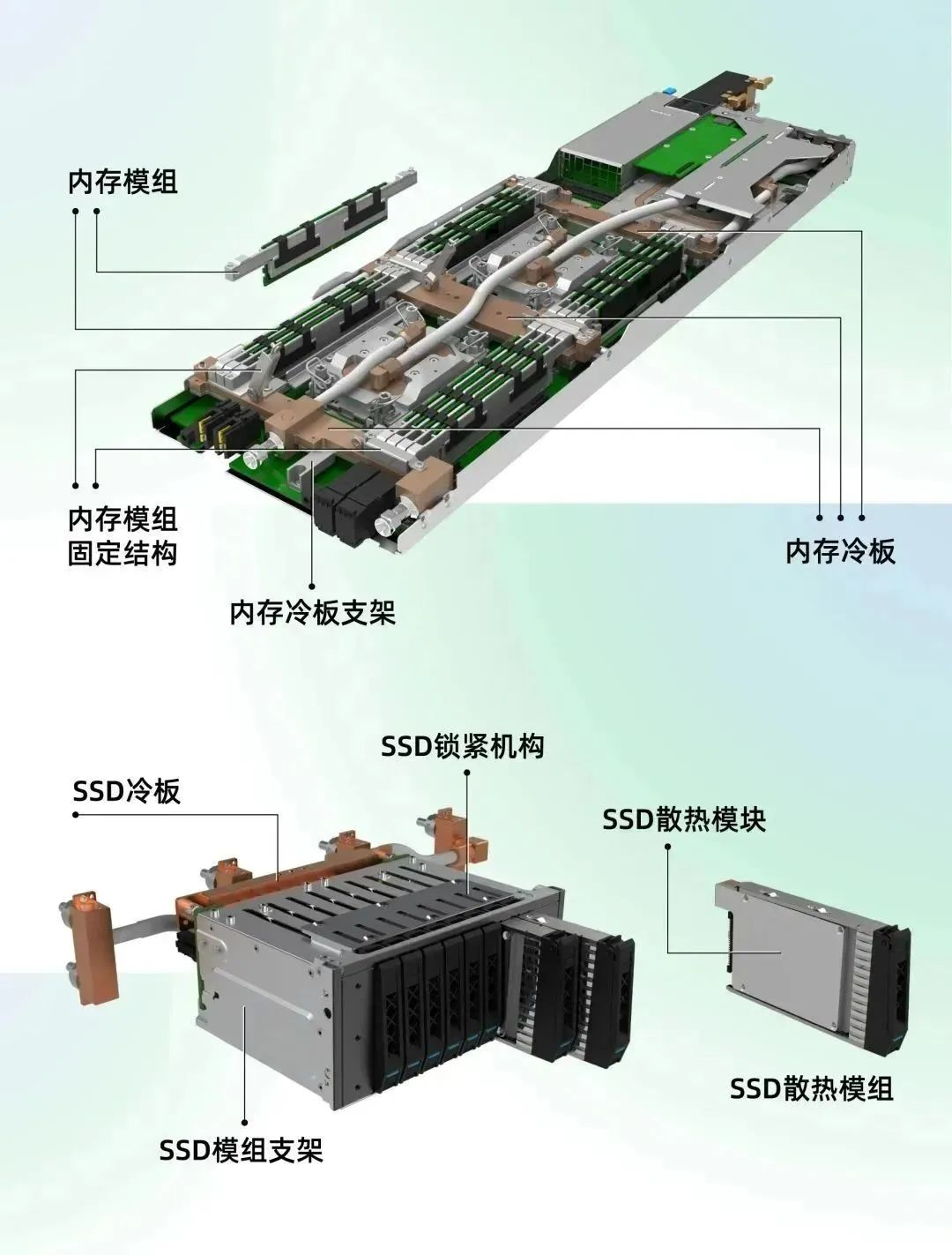

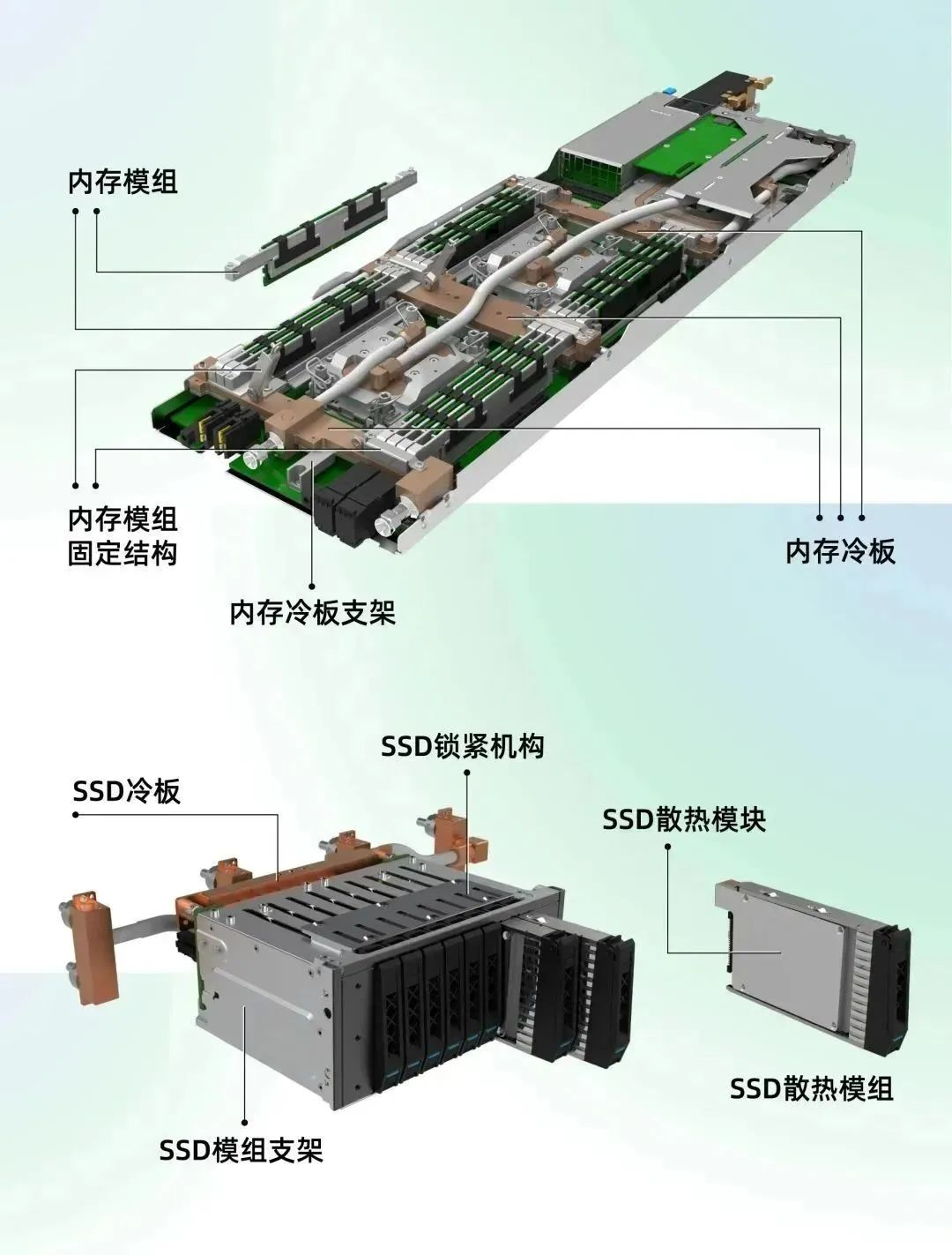

不过,为了推动液冷产业的成熟和规模化,浪潮信息做了很多努力和尝试,比如针对内存、硬盘液冷散热,首创了内存枕木液冷方案及创新的硬盘液冷方案,实现无水换热与热插拔,在实现高密算力的同时,不但可以大幅降低成本,缩短开发周期,还可有效提升安全可靠性。

根据IDC的数据,2023年,浪潮信息的液冷服务器市场占比中国第一。浪潮信息天池液冷产业基地已经实现了液冷产品的标准化、品质化、系列化生产,年产能超10万台。

建立标准是当务之急

“技术成熟,但产业不成熟”是当前液冷产业的现状。而形成这种格局的背后,是液冷行业缺少统一的产业标准体系,缺乏产业分工。

“液冷服务器的标准化程度不高,兼容性不足,这是我们现在在液冷服务器推广上面临最大的困难。”赵帅说。产业链上各个企业技术路径多种多样、产品规格千差万别,产品质量良莠不齐,各液冷模块无法兼容,让用户的获取成本和使用门槛变高。

Gartner在《2023中国ICT技术成熟度曲线》报告中也提到这一点,可持续数据中心技术的标准化依然处于滞后状态,一些行业标准仍在讨论中,例如液冷标准及规范亟待完善,而对于发布的标准市场需要时间来实施。

同时,新技术由于缺乏长周期、规模化部署验证,用户对于技术的可靠性、安全性、有效性等存在疑虑,需要通过更完善、详细的规范和标准来指导产业生态从混乱走向有序,持续创新提升技术成熟度,实现标准化和快速应用,从而建立市场信心。

建立液冷行业的标准体系成为当务之急。2024年1月,浪潮信息与英特尔联合发布全球首个全液冷冷板参考设计,推出全液冷冷板服务器最佳实践。

一方面,双方从系统级解决方案出发,以模块化解耦设计思维,兼容不同厂商和型号的计算设备,探索高能效、易于运维、使用更安全,兼容性更出色的全液冷冷板服务器设计;另一方面,通过设计开放,对产业探索全液冷冷板解决方案,加速全液冷冷板技术的普及和规模化应用,推动产业化进程。

英特尔解决方案咨询顾问李昌中透露,一年多前,英特尔与浪潮信息携手,希望共同打通液冷产业的最后一公里,降低液冷的成本,推动液冷产业化落地,双方共同秉持对整个产业界和生态系统开放的理念,希望把成果以开放的形式共享给全产业。

最终,双方联合中国电子技术标准化研究院和开放计算标准工作委员会(OCTC),共同打造了《全液冷系统参考设计及测试白皮书》,里面既有参考设计,也有实践的验证和对未来的思考展望。

除了全液冷参考设计白皮书,浪潮信息已参与制定并发布了十余项冷板式液冷、浸没式液冷相关设计技术标准,比如牵头编制并发布了国内首批冷板式液冷核心部件团体标准,填补了冷板式液冷数据中心标准的空白,同时牵头制定了《集装箱式数据中心机房通用规范》和《模块化数据中心通用规范》国家标准。

赵帅说,浪潮信息这么做,一是让客户意识到他们顾虑的问题已经有人去解决了,增强用户对液冷的信心;二是我们所做的冷板液冷系统和标准经过了产业化实践认可,能够进行批量化,大规模的部署和快速的落地。

而且很多问题只有大规模的产业实践后才会发现,浪潮信息希望把发现的问题形成标准,形成一个指导规范,从而能够更快、更好地引爆市场,让一些对液冷持观望态度的客户,能进入快速部署的阶段。

2022年,浪潮信息将“All in液冷”纳入公司发展战略,目前全系产品都支持液冷,并且提出2025年实现“风液同价”的目标。这也意味着需要更加开源开放,做标准建设,让大家都用起来,实现规模效应。

“如果你只做自己的事情,你的液冷始终是高高在上,很难做到风液同价,这就是我们做标准最大的意义和价值。”赵帅说。

注:本文转载自科技自媒体“数智前线”官微

![]()

第八代服务器

第八代服务器 第七代服务器整机柜服务器高密度服务器

第七代服务器整机柜服务器高密度服务器